この記事が含む Q&A

- 「Assistive Access」機能はどのように認知機能に困難を抱える人を支援しますか?

- 重要な機能のみを抽出したシンプルなインターフェースで認知的負荷を軽減します。

- 「Live Speech」機能はどのように言葉を発声できない人をサポートしますか?

- タイピングした内容を通話や会話中に音声で読み上げることができます。

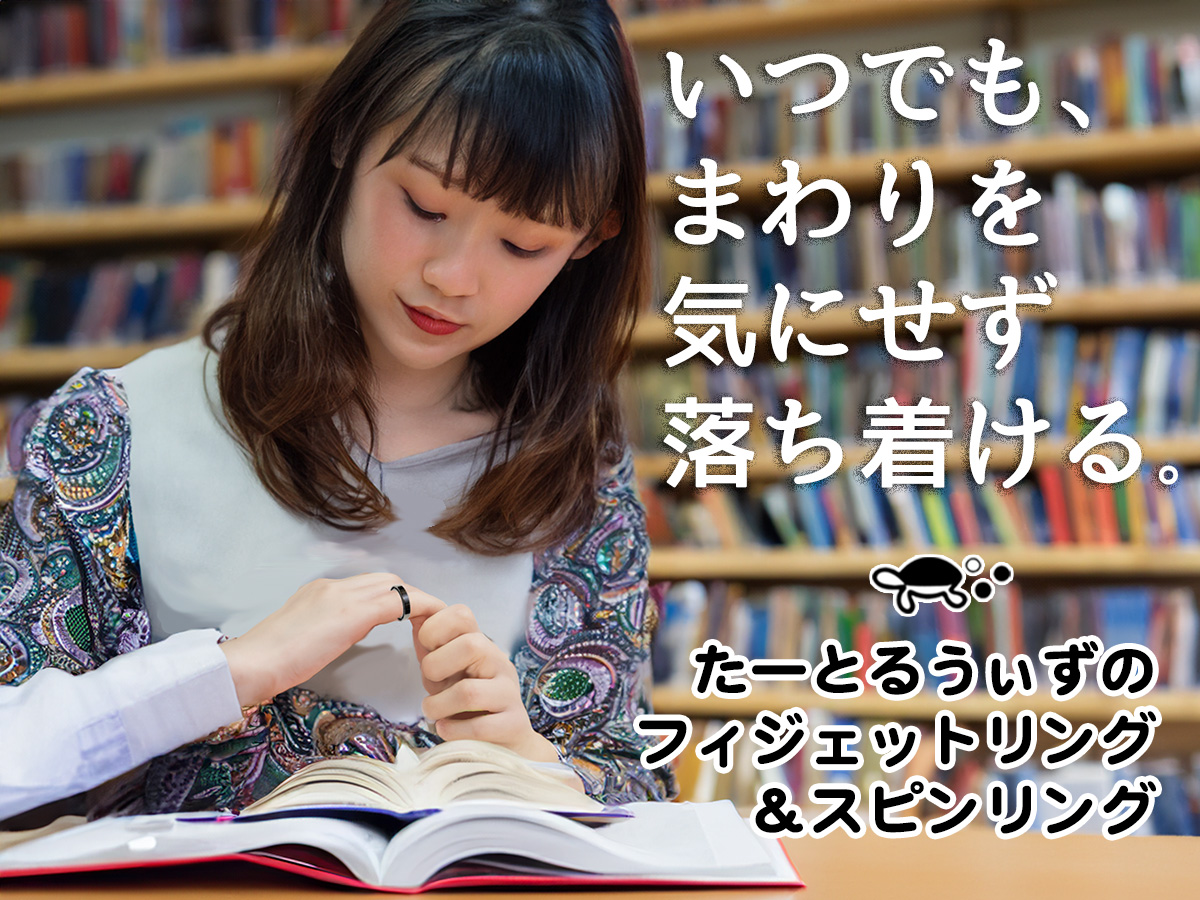

Appleは2023年後半から利用できる予定の、知的障害や発達障害などにより認知機能に困難をかかえる人や、言葉を発声できない人、発声することができなくなるリスクがある人たちを助けるiPhoneやiPadの新機能について発表しました。

認知機能に困難をかかえる人は「Assistive Access」によって簡単に、自立してiPhoneとiPadを使えるようになります。

言葉を発声できない人は「Live Speech」を使って通話や会話の際にタイプして話せるようになります。

また、発声することができなくなるリスクのある人は「Personal Voice」を使って自分が話しているように聞こえる合成音声を作っておくことで、家族や友人とつながることができます。

「Assistive Access」は、アプリケーションと体験から重要な機能を抜き出すデザインによって認知的負荷を軽減します。

認知機能に問題をかかえる人や支援者からの声を反映し、大切な人とつながったり、写真を撮影して楽しんだり、音楽を聴いたりすることに重点を置いた機能です。

この機能は、高コントラストのボタン、大きな文字のラベル、および信頼する支援者が被支援者に合わせて体験を調整するのに役立つツールを備えた、独自のインターフェイスを提供します。

たとえば、視覚的にコミュニケーションを取ることを好むユーザー向けに、メッセージには絵文字のみのキーボードや、ビデオメッセージを撮影して大切な人と共有するためのオプションのみを表示させます。

さらにユーザーや支援者は、ホーム画面とアプリケーション向けのさらに視覚的なグリッドベースのレイアウト、またはテキストをより好むユーザー向けの行ベースのレイアウトを選ぶことができます。

「知的障害および発達障害の人たちは創造性にあふれていますが、このような人たちにとってテクノロジーが物理的、視覚的、知識的な障壁となっていることがよくあります。

iPhoneやiPadに認知的に利用しやすい体験を提供できる機能があることによって、教育、雇用、安全、自立への扉がさらに開くことになります。

それは世界を広げ、可能性を大きくすることを意味します」

そう、The Arc of the United StatesのNational Program Initiativesのシニアディレクターであるケイティ・シュミットは述べています。

また、iPhone、iPad、Macの「Live Speech」機能は、発話できない、または徐々に発話能力を失っている、世界中の何百万人もの人々をサポートするために設計されました。

ユーザーは、電話、FaceTime通話、対面での会話中に自分が話したいことをタイプして読み上げてもらうことができます。

また、よく使うフレーズを保存しておいて、家族、友人、同僚と実際に会話する際にすばやくそれを挟み込むこともできます。

ALS(筋萎縮性側索硬化症)や次第に発話能力に影響が及ぶ可能性のあるその他の病気の診断を受けてまもない人など、発話能力を失うリスクがあるユーザーにとって、「Personal Voice」機能は自分が話しているように聞こえる声をシンプルかつ安全に作ることができる方法となります。

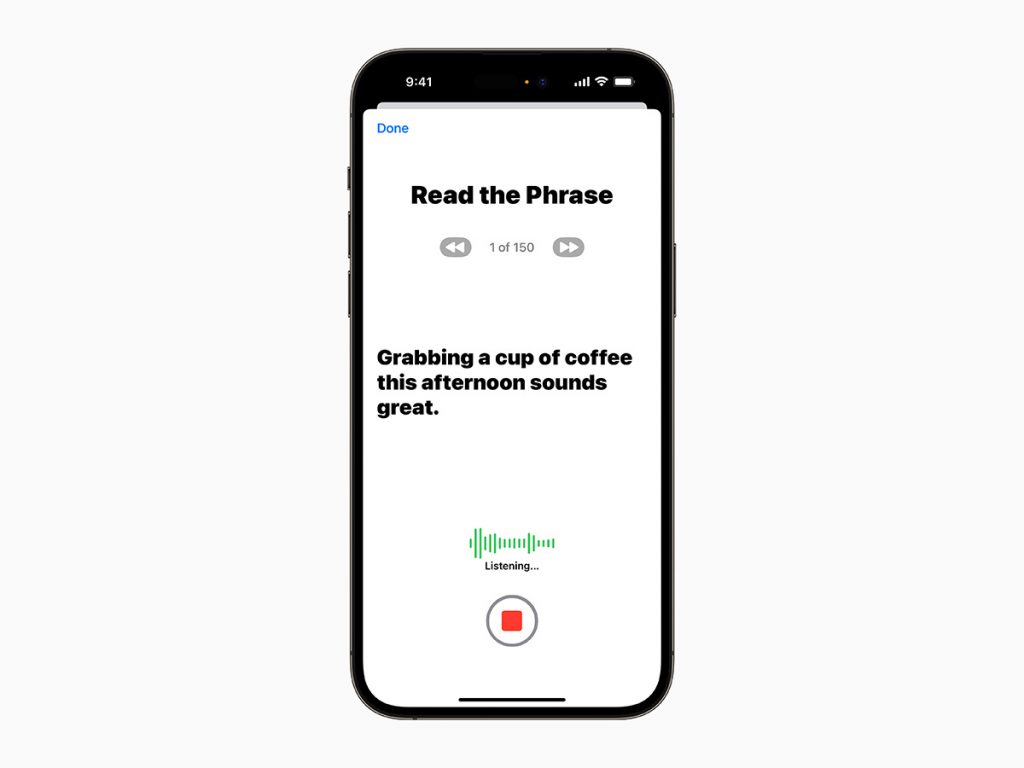

ユーザーは、iPhoneまたはiPadでランダムに選ばれた文章のセットを声に出して読んで15分間録音することで、「自分の声」を作成できます。

Live Speech機能とあわせて利用でき、自らの口で話すことができなくなってもユーザーが大切な人とつながる時に自分の声で話すことを可能にします。

そのほか、視覚障害のあるユーザー向けの、拡大鏡の検出モードでユーザーが指し示したテキストを識別して読み上げることで家電などの操作をサポートする「Point and Speak」機能なども提供されます。

(出典・画像:Apple)

すごく単純な画面にして使いやすくする。

そうした、デザインによるものだけでなく、AI技術により、

自らの声を失ってしまう前に15分間話すだけで、iPhoneが自分の声を再現しそれで話をすることができる。

素晴らしいです。

ますます、こうした方向への進化も期待しています。

(チャーリー)